Par François Rehulka

08/08/2025

Temps de lecture : 15 min

Malgré l’image d’alliée de la transition écologique que véhiculent les acteurs du numérique, l’intelligence artificielle (IA) soulève des questions environnementales de plus en plus pressantes.

Derrière les promesses, son essor rapide entraîne une forte croissance de la consommation énergétique, encore difficile à appréhender dans les cadres actuels de la responsabilité sociétale des entreprises (RSE).

Ce décalage crée une illusion de vertu : des projets IA qui semblent durables en surface, mais dissimulent un impact bien réel. Peut-on vraiment concilier ambitions écologiques et usages massifs de l’IA ? Quelques clefs de compréhension ici.

Un levier pour la transition... ou un accélérateur de dérives ?

L’IA est souvent présentée comme un levier technologique pour accélérer la transition écologique. Selon certaines études, son développement dans des secteurs clés pourrait réduire jusqu’à 4 % les émissions mondiales de CO₂ d’ici à 2030. Jusqu’à aujourd’hui, l’IA industrielle a été déployée dans certains secteurs pour des bénéfices environnementaux parfois mesurables, et parfois encore à démontrer : opérations de maintenance prédictive pour prolonger la durée de vie des machines, optimisation des chaînes logistiques pour réduire la consommation de carburant, régulation intelligente de l’énergie.

Mais avec l’essor récent des IA "génératives" (chatbots, assistants de codage, création de contenu), son utilisation a fait son entrée chez les salariés de bureau et le grand public, entraînant une explosion de la consommation numérique comme le montre le développement croissant des data centers : d’après l’Agence Internationale de l’Energie (AIE), près de 100 GW étaient installés en 2024, contre un peu plus de 30 GW en 2015 et 20 GW en 2005.

Désormais, chaque employé peut réaliser en quelques clics et prompts ce qui aurait autrefois pris des heures. Comment ne pas se laisser tenter, a minima pour rester dans la course à la productivité ? En conséquence, le secteur tertiaire, autrefois considéré à faible impact, se transforme aujourd’hui en moteur majeur de la croissance de la demande électrique mondiale.

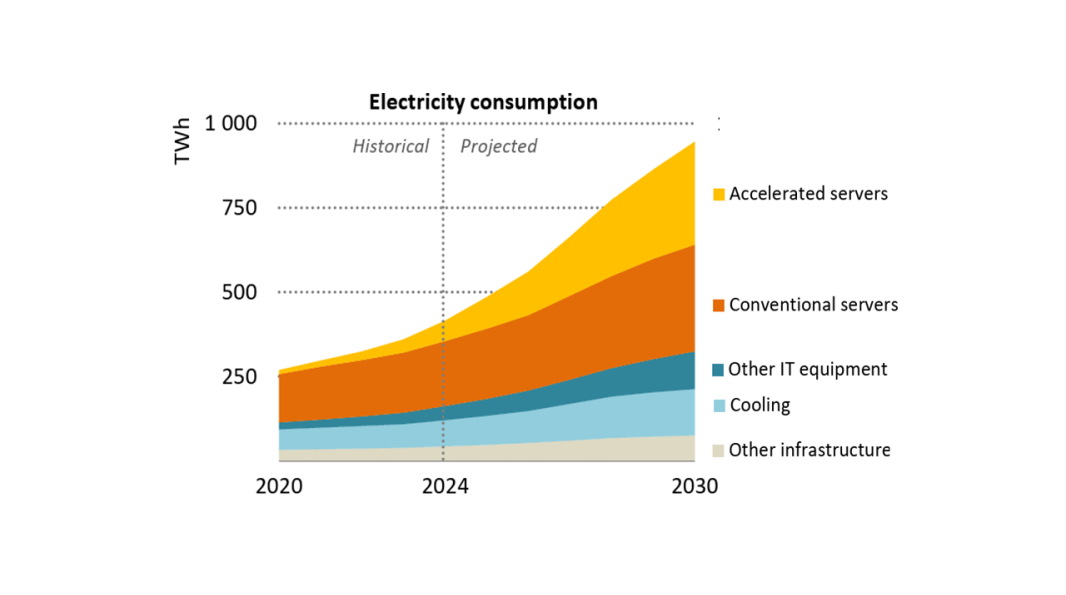

Selon certains scénarios de l’AIE, l’essor de l’IA générative pourrait plus que doubler d’ici 2030 pour atteindre jusqu’à 1000 TWh, soit 3% de la consommation électrique mondiale, représentant une augmentation de 15% / an, soit quatre fois plus vite que la croissance de la consommation totale. Les entreprises peuvent donc apparaître durables dans leurs rapports RSE tout en externalisant une empreinte numérique qui échappe aux indicateurs.

Projection de la consommation d’électricité des datacenters d’après l’AIE (cas de base).

Transcription

Projection de la consommation d’électricité des datacenters d’après l’AIE (cas de base).

Source : Energy and AI, 2025, Agence Internationale de l'Énergie (AIE).

L’autre effet pervers est bien connu des économistes : c'est l’effet rebond. En rendant la production de contenus ou d’analyses plus rapide et moins coûteuse, l’IA génère une fuite en avant des usages. Les gains d’efficacité obtenus sur une tâche donnée (par exemple : rédiger un rapport plus rapidement) sont rapidement annulés par la multiplication du nombre de tâches réalisées (produire dix rapports au lieu d’un). L’amélioration de l’efficience ne se traduit alors pas par une baisse de la consommation globale, mais au contraire par une hausse exponentielle de celle-ci.

Ce mécanisme, déjà observé pour de nombreuses technologies depuis la révolution industrielle, entre en conflit direct avec les objectifs de sobriété affichés par les stratégies RSE. Sans garde-fous, l’IA risque de devenir un accélérateur à double tranchant : un puissant atout de productivité d’un côté, mais un vecteur d’accroissement du dérèglement climatique de l’autre.

Efficace, oui. Durable et sûr ? Moins certain...

Source : Le géant de la gaffe, Franquin

Transcription

Efficace, oui. Durable et sûr ? Moins certain...

Source : Le géant de la gaffe, Franquin

Un tour d’horizon de l’empreinte environnementale de l’IA

Malgré une immatérialité apparente, l’IA repose sur une infrastructure physique importante et gourmande en ressources, dont l’empreinte s’étend sur tout le cycle de vie.

Du silicium…

Le voyage débute dans les mines où sont extraits minerais et terres rares indispensables aux composants électroniques. La fabrication des semi-conducteurs (en particulier des GPU, ces puces électroniques très performantes pour les calculs nécessaires à l'IA, et qui sont les moteurs de l’IA générative) est un processus extrêmement énergivore et consommateur d’eau, réalisé dans des fonderies de pointe. Viennent ensuite l’intégration dans les serveurs puis la construction des datacenters pour les héberger, avec des émissions carbone embarquées déjà importantes avant la première utilisation du moindre algorithme.

… au serveur

La course à la puissance de calcul que se livrent les géants du numérique entraîne une obsolescence accélérée du matériel. Les géants du secteur comme Nvidia ont accéléré leur cycle d'innovation, passant d'une nouvelle architecture de puces tous les deux ans à un rythme annuel. Dans les datacenters, un GPU (Graphics Processing Unit) haute performance pour des usages IA n’est exploité en moyenne que 1 à 3 ans avant d’être remplacé. Ce renouvellement intensifié accroît la crise des déchets électroniques : la quantité d’e-waste, les déchets d'équipements électriques et électroniques, augmente déjà cinq fois plus vite que les capacités de recyclage actuelles.

De plus, ce rythme rend difficile (voire illusoire ?) tout "amortissement carbone" des équipements, car l’efficacité énergétique d’une technologie doit être doublée si sa durée de vie est réduite de moitié, pour compenser l’impact carbone initial de leur fabrication sur un cycle aussi court.

Les limites des pratiques actuelles de décarbonation de la consommation des datacenters. Face à l’augmentation exponentielle de leurs besoins, les opérateurs de cloud multiplient les annonces d’alimentation 100% renouvelable via des Power Purchase Agreements (PPA) ou des achats de Garanties d’Origine (GO).

Mais cet outil contractuel a ses limites. D’une part, beaucoup de PPA manquent d’additionnalité réelle : ils consistent souvent à acheter l’énergie d’un parc renouvelable existant ou qui aurait été développé même sans PPA, mais dans des conditions financières différentes. D’autre part, il est important de relativiser le rôle de ces arrangements contractuels pour le développement des énergies décarbonées.

Ce sont avant tout des instruments de sécurisation financière pour les développeurs et les consommateurs d’énergie (et historiquement boostés aux États-Unis par des dispositifs de crédits d’impôt) permettant une sécurisation du coût d’approvisionnement de l’électricité. Entre opportunité économique et véritable démarche RSE, les communications insistent surtout sur ce dernier aspect.

L’utilisation : entraînement et inférence. Deux phases constituent le cycle de vie d’un modèle IA : la phase d’entraînement et la phase d’inférence. Lors de l’entraînement, le modèle "apprend" à partir de grands volumes de données pendant plusieurs semaines ou mois. L’entraînement du modèle GPT-3 aurait ainsi consommé environ 1287 MWh d’électricité, et 10 000 à 30 000 MWh pour GPT-4, soit l’équivalent de la consommation moyenne annuelle de 4500 à 13500 citoyens français.

La phase d’inférence, l’utilisation quotidienne du modèle pour répondre aux requêtes, présente un coût énergétique unitaire faible, mais répété des milliards de fois. In fine, l’impact environnemental de l’IA se joue moins lors de l’entraînement que dans la somme des usages quotidiens en grand nombre qui suivent. Réduire cet impact nécessite donc de s’attaquer avant tout à la sobriété d’usage des modèles une fois déployés.

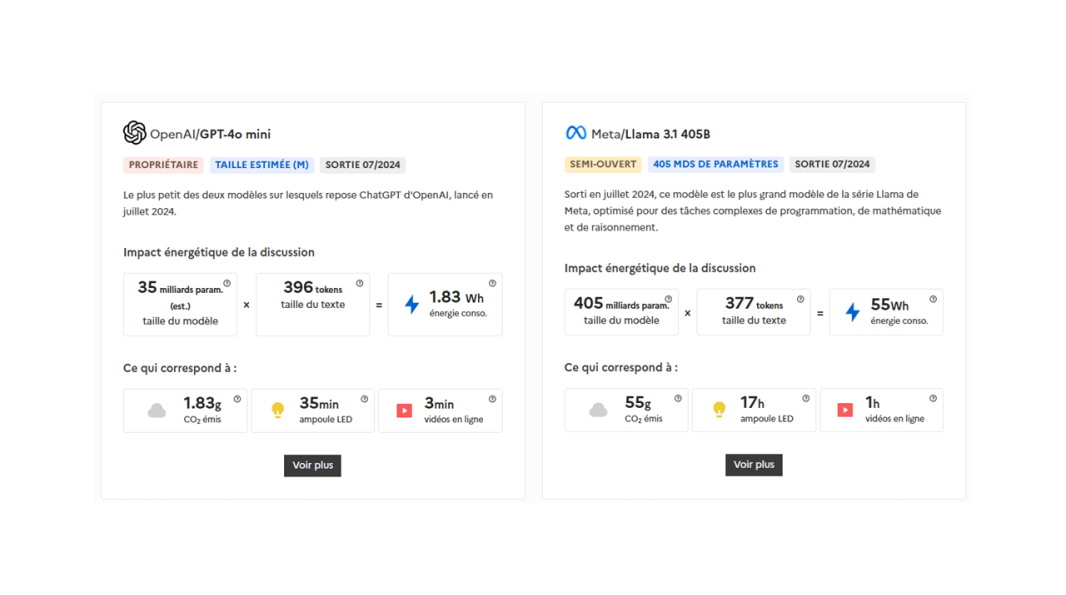

Le coût variable d’une requête IA. Toutes les requêtes adressées à une IA ne se valent pas sur le plan énergétique. Le coût énergétique unitaire varie fortement selon la complexité de la tâche, la taille du modèle mobilisé et la longueur de la réponse demandée. Une requête type sur ChatGPT (GPT-4o) consomme aujourd’hui en moyenne environ 0,34 Wh selon Sam Altman, CEO d’OpenAI, soit une quantité d’énergie comparable à 10 fois celle d’une recherche Google classique (estimée à 0,03 Wh en 2024).

Cependant, certaines tâches complexes, en particulier celles mobilisant des modèles complexes (raisonnement avancé, recherche approfondie, génération d’images ou de vidéos), peuvent entraîner une consommation bien plus élevée. Des études récentes montrent que l’exécution d’une même tâche sur un modèle sophistiqué peut consommer jusqu’à 50 fois plus d’énergie que sur un modèle léger ou frugal. D’autres travaux estiment que certains modèles de pointe comme DeepSeek-R1 ou OpenAI o3 peuvent consommer jusqu’à 33 Wh par requête, soit près de 100 fois plus que des modèles compacts.

Ces écarts soulignent un point fondamental : le choix du modèle (taille, puissance) et la nature de la tâche ont un impact direct sur l’empreinte environnementale. Une même demande utilisateur peut ainsi être traitée avec des niveaux de consommation très différents, selon l’approche choisie. Cela renforce l’intérêt de stratégies de sobriété fonctionnelle : utiliser des modèles frugaux pour les tâches simples, éviter les successions de requêtes mal formulées, et réserver les modèles lourds aux usages le nécessitant réellement. Sans cette discipline d’usage, l’efficacité énergétique apparente des nouvelles générations de modèles pourrait être rapidement neutralisée par la croissance exponentielle des sollicitations.

IA et RSE : le grand écart

Compte tenu de cette empreinte complexe et en forte croissance, les pratiques actuelles de mesure et de reporting des entreprises, qu’elles soient fournisseurs ou utilisatrices de solutions d’IA, se révèlent insuffisantes.

Côté fournisseurs : la croissance contre la durabilité. Les grandes entreprises du numérique affichent des objectifs environnementaux ambitieux, à l’image de Microsoft, qui vise la neutralité carbone d’ici 2030. Mais les chiffres révèlent une réalité plus complexe : depuis 2020, les émissions totales de Microsoft ont augmenté de 23,4 %, principalement en raison de la croissance rapide de ses infrastructures liées à l’intelligence artificielle (construction de data centers, déploiement de serveurs spécialisés, etc.).

Si les émissions directes (scopes 1 et 2) ont diminué de près de 30 %, notamment à l’aide de PPA, cette réduction est largement compensée par la hausse des émissions indirectes (scope 3). Ces dernières représentent aujourd’hui plus de 97 % de l’empreinte carbone de l’entreprise et ont augmenté de 26 % sur la même période.

Google présente un diagnostic similaire. Dans son rapport 2025, l’entreprise indique une augmentation de 11 % de ses émissions globales par rapport à 2023. Là encore, la croissance des infrastructures nécessaires à l’IA explique ce constat : les émissions scope 3 de Google ont augmenté de 22 % en un an, compensant largement les réductions obtenues de 11% sur les scopes 1 et 2 (obtenues en partie également grâce à des PPA).

Ces données confirment que, malgré les trajectoires affichées de décarbonation, le déploiement rapide de l’IA contribue activement à l’augmentation de l’empreinte environnementale du numérique.

Côté utilisateurs : l’angle mort du scope 3. Pour les entreprises clientes qui intègrent des services IA, l’essentiel de l’impact carbone est noyé dans le scope 3, plus précisément sous la catégorie "Achats de biens et services".

Sans mesure exacte des usages IA et l’utilisation de facteurs d’émission spécifiques, les émissions générées pour les calculs d’IA sont invisibilisées. Les méthodes de comptabilité carbone actuelles sont souvent fondées sur les catégories de flux financiers et échouent à refléter la réalité technique tant qu’elles ne sont pas réalisées de manière plus granulaire et alimentées par des données d’activité physique.

En pratique, l’impact de l’IA constitue donc un angle mort dans la comptabilité carbone des entreprises utilisatrices. Les risques : biais d’information (des bilans RSE incomplets pouvant tromper sur la performance environnementale réelle) et inertie managériale (car ce qui n’est pas mesuré a peu de chances d’être piloté et réduit).

Des leviers pour une IA sobre et transparente

Sortir de l’impasse des limites actuelles nécessite un changement de paradigme, tant chez les fournisseurs que chez les utilisateurs, soutenu par des initiatives collectives.

Pour les fournisseurs de solutions IA, l'enjeu principal est d’accroître radicalement la transparence et d’assumer la responsabilité de bout en bout de l’empreinte de leurs services. Les clients utilisateurs doivent pouvoir exiger :

- Des analyses de cycle de vie (ACV) complètes et régulières de chaque service IA, fournies par le prestataire ou des experts spécialisés. Il ne s’agit pas simplement de communiquer des données statiques a posteriori, mais de mettre à disposition des informations dynamiques, reflétant l’évolution des modèles et des infrastructures au fil du temps (montées de version, changements matériels, etc.). Mistral AI, acteur français, a déjà ouvert la voie vers plus de transparence un publiant en juillet 2025 une étude de son impact environnemental.

- Une information en temps réel de l’utilisateur sur l’impact de ses requêtes. Idéalement, chaque appel à une API ou chaque requête sur une plateforme IA devrait s’accompagner d’une estimation instantanée de son coût énergétique, carbone et eau. De tels indicateurs intégrés sensibiliseraient les usagers et guideraient des choix plus sobres (par exemple, sélectionner un modèle moins complexe si l’usage ne le requiert pas).

- Une contribution active à l’élaboration de standards communs de comptabilité carbone pour l’IA. Cela implique de dépasser les approches propriétaires et de collaborer, au sein de coalitions ou d’instances de normalisation, à la définition de méthodologies partagées. Des initiatives émergent en ce sens, et les fournisseurs ont intérêt, pour prouver leur engagement environnemental, à y prendre part pour coconstruire des référentiels adaptés au secteur. Là encore, la récente initiative de Mistral AI en partenariat avec l’ADEME est bienvenue.

Pour les entreprises utilisatrices d’IA, il est nécessaire de gouverner les usages en interne pour éviter la dérive d’une consommation incontrôlée. Quelques axes d’action :

- Mesurer l’usage. La Direction des Systèmes d’Information, en lien avec la direction RSE, doit mettre en place un suivi interne des requêtes IA : combien et pour quels types de tâches ? Un tel monitoring permettrait de faire sortir l’impact de l’IA du flou du scope 3 en le rendant visible et quantifiable.

- Questionner le besoin. Développer une véritable culture de la sobriété numérique est essentiel. Cela passe par un réflexe collectif : se demander, avant chaque utilisation, si le recours à l’IA est pertinent et proportionné pour la tâche envisagée. Peut-on s’en passer ? À défaut, peut-on utiliser un modèle plus léger ? En général : oui, si l’échéance fixée en interne sur la production du livrable est raisonnable… bannir le réflexe d’utiliser systématiquement le modèle le plus puissant par défaut, c’est réduire les gâchis de calcul et donc d’énergie.

- Former les équipes. Les collaborateurs doivent être sensibilisés et formés aux bonnes pratiques d’une IA responsable. Par exemple, apprendre la sobriété des prompts : formuler des requêtes précises, bien ciblées, pour éviter des itérations inutiles et coûteuses (en énergie et carbone, mais aussi en temps de travail), et savoir choisir le modèle adapté à la requête, et donc avoir une connaissance des modèles disponibles. De même, diffuser des ordres de grandeur d’impact aide à prendre conscience des conséquences de ses usages.

- Ouvrir un dialogue sur la sobriété et le "droit à ne pas utiliser l’IA". Il s’agit d’encourager une culture où les collaborateurs peuvent légitimement questionner le recours systématique à l'IA, au nom de la sobriété et de la cohérence environnementale. Cela implique pour l'entreprise d'être prête à arbitrer entre un gain de productivité et le respect de ses engagements RSE.

- Préserver le capital humain en protégeant l’apprentissage des juniors. Le débat est déjà très prégnant au sein de l’éducation nationale, mais l’apprentissage ne s’arrête pas au terme des études. Une gouvernance responsable de l'IA doit prévenir les impacts sur le développement des compétences des plus jeunes collaborateurs. En agissant comme une "béquille cognitive", l'IA peut les priver des tâches formatrices (recherche, synthèse, analyse, etc.) et des erreurs nécessaires à l'acquisition d'un savoir-faire pérenne. Ce sont par ailleurs les compétences d’analyse critique, basées sur des compétences métiers spécifiques, qui permettent une utilisation efficiente (et intelligente) de l’IA. Il est donc important d'encadrer les usages : définir les tâches où l'IA est une assistance utile et celles où un travail "IA free" reste indispensable à la montée en compétences, afin de garantir que l'IA augmente les capacités sans se substituer aux compétences en développement.

Des initiatives qui vont dans le bon sens. En parallèle de ces actions volontaires à développer, le contexte réglementaire et industriel commence à évoluer. Quelques signaux encourageants :

- Réglementation. L’AI Act européen, en application depuis 2024 et renforcé en août 2025, introduit de nouvelles exigences de transparence sur la consommation de ressources des modèles d’IA. En France, la loi REEN de 2021 (Réduction de l’Empreinte Environnementale du Numérique) impose aux opérateurs et hébergeurs de publier des données environnementales sur les datacenters. Ces cadres légaux posent les bases d’une responsabilité accrue de la filière.

- Outils de mesure. L’écosystème technologique se mobilise également. Des librairies open source comme Code Carbon ou des plateformes comme Ecologits permettent d’estimer l’empreinte carbone du code et des entraînements de modèles, permettant aux développeurs une traçabilité de l’impact de leur travail. Également, Hugging Face a lancé le projet "AI Energy Score", qui donne aux modèles IA des notes d’efficacité énergétique afin de faciliter les comparaisons entre algorithmes. Ce type d’initiative incite à valoriser les approches techniques plus économes en ressources.

- Standards et coalitions. Des initiatives de normalisation émergent désormais pour cadrer l’IA frugale : le référentiel AFNOR SPEC 2314 propose un ensemble de bonnes pratiques pour une IA plus sobre, tandis que les travaux ISO/IEC, via le JTC 21, préparent les versions normatives internationales. Aux États-Unis, l’IEEE, via l’ITCC, fédère chercheurs et industriels autour de standards techniques de Green AI.

Vers une IA vraiment responsable

L’IA est un outil puissant dont l’impact environnemental et social dépendra entièrement des règles et des limites que nous lui fixerons. Le danger serait de laisser prospérer une "responsabilité artificielle" : communiquer abondamment sur quelques projets vitrines ou sur des gains de productivité, tout en fermant les yeux sur l’impact systémique d’un déploiement massif et non maîtrisé. Pour éviter cet écueil, l’enjeu fondamental est d’intégrer l’IA dans une gouvernance d’entreprise élargie, et non de la cantonner à un débat technique opaque.

La responsabilité environnementale de l’IA doit devenir un sujet de gouvernance à part entière, discuté au plus haut niveau stratégique. La transparence doit être exigée à tous les niveaux de l’écosystème numérique : sans données fiables et partagées sur les empreintes, aucun pilotage pertinent n’est possible. C’est une culture de la sobriété qu’il faut insuffler dans tous les usages numériques de l’entreprise.

Chaque utilisateur, chaque décideur, doit intégrer la notion que chaque requête a un impact bien réel.

L'auteur

François Rehulka

François est Senior Manager Technique chez Urbanomy, où il est responsable du développement de l'expertise technique de la société et de la qualité de ses missions.

Diplômé de l'École des Mines de Nantes, il a 18 ans d'expérience dans le secteur de l'énergie, sur les marchés de l'énergie, la recherche sur la décarbonation, l'optimisation des systèmes énergétiques locaux, la recherche sur la décarbonation, la stratégie de développement et la gestion de projets d'innovation.

Ces articles pourraient vous intéresser

Newsletter

Loi Duplomb, prolongation de PACTE Industrie, logements bouilloires : actualités été 2025

Nos accompagnements

Décarboner votre portefeuille immobilier : cadre, méthode et retour d'expérience